Сервера IBM System p, в совокупности с ОС AIX и опцией Advanced POWER Virtualization [1], дают возможность выбора из трех механизмов управления ресурсами и рабочей нагрузкой: Общие процессоры, разделы без ограничений (uncapped). Гипервизор POWER передает неиспользованные процессорные такты тем разделам без ограничений, которые могут получить от них пользу. Workload Manager (Менеджер рабочей нагрузки, WLM). Устанавливает приоритеты приложений на доступ к: ЦП, памяти и подсистеме в/в в пределах раздела. Partition Load Manager (Менеджер загрузки разделов, PLM) [5, 6]. Добавляет в раздел и перемещает между разделами ресурсы ЦП и памяти, используя динамические операции LPAR. Два режима работы: мониторинга и управления.

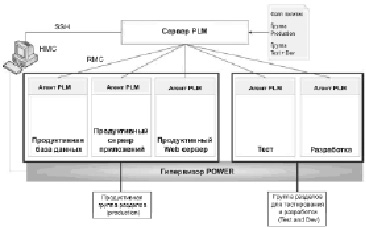

Для улучшения использования системных ресурсов PLM автоматизирует миграцию ресурсов между разделами, основываясь на загрузке и приоритетах разделов; разделы с большими запросами будут получать ресурсы, добровольно отданные или принудительно отобранные у разделов с меньшими запросами. Определяемые пользователями политики управляют тем, как будут перемещаться ресурсы. Приложение PLM использует модель «клиент-сервер», показанную на рисунке 1, для предоставления совместного доступа к системной информации, такой как события процессора и памяти, всем одновременно работающим логическим разделам [2, 3].

Рис. 1. Архитектура PLM

Так как каждый раздел контролируется локально, и агенты взаимодействуют с сервером PLM только при возникновении события, PLM потребляет незначительное количество системных и сетевых ресурсов. Политика управления ресурсами (resource management policy) для каждой группы разделов (partition group) указывается в файле политики (policy file), который определяет, как управляемое окружение, так и параметры политики управления ресурсами [4, 5]. Файл политики управления ресурсами содержит: 1) описание основных ресурсов виртуального сервера; 2) макс., мин. и гарантированные значения ресурсов: ЦП и память; 3) шаг наращивания или уменьшения выделенных ресурсов; 4) список виртуальных серверов в пуле, которые будут выступать в роли доноров или акцепторов дополнительных ресурсов; 5) описание интервалов опроса ЦП и памяти на предмет необходимости корректирования объема выделенных ресурсов; 6) пороговые (мин/макс) значения загрузки ЦП и памяти. Каждый раз, когда преодолевается пороговое значение, PLM получает событие Системы управления и контроля – Resource Management and Control (RMC). Когда загрузка ресурса превышает верхнее пороговое значение, раздел PLM считает, что раздел нуждается в дополнительных ресурсах; такой раздел называется requestor (реципиент). Когда загрузка раздела становится меньше, чем нижнее пороговое значение, раздел становится потенциальным донором (donor). При нормальном стечении обстоятельств ресурсы перемещаются от доноров только тогда, когда другой раздел переходит в состояние requestor для того же ресурса. Когда загрузка ресурса находится между двумя пороговыми значениями, PLM считает, что доступных ресурсов достаточно. 7) опции необходимости немедленного освобождения ресурсов, которые больше не используются, поскольку можно «придержать» ресурсы во избежание слишком частых операций по перемещению ресурсов, которые также требуют времени.

Часть определения политики – относительный приоритет каждого раздела в группе. Это достигается путем использования механизма «общих ресурсов» (shares) аналогичного WLM. Чем больше «shares» выделено разделу, тем выше его приоритет. Чтобы предотвратить полное истощение количества ресурсов в некоторых разделах, PLM модулирует приоритет раздела на основе его текущего количества ресурсов.

Когда PLM оповещается о том, что раздел перешел в состояние реципиента, он ищет свободные ресурсы в следующем порядке: свободный пул неразмещенных ресурсов; донор ресурсов; раздел с наименьшим количеством общих (требуемых) ресурсов, имеющий при этом больше ресурсов, чем указано в параметре настройки «guaranteed» (гарантировано).

Количество перемещаемых ресурсов – либо минимальное дельта значение для обоих разделов, либо количество, которое даст им приоритет, указанный в политике.

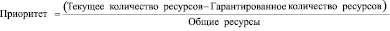

Определение, какой из узлов больше или меньше требуется в ресурсах, выполняется путем сравнения того, каким количеством ресурсов владеет раздел относительно его приоритета, определяемого, в свою очередь, по количеству «общих ресурсов». PLM ранжирует разделы, включая раздел requestor, в списке разделов с количеством ресурсов, превышающих гарантированное значение. Приоритеты разделов определяются по следующему соотношению [2, 3]:

. (1)

. (1)

Наименьшее результирующее значение означает наивысший приоритет; разделы с меньшим значением могут получать ресурсы от разделов с большим значением. На рис. 2 показан процесс перемещения ресурсов ЦП для трех разделов. Раздел 3, загруженный, является просителем. В пуле нет свободных ресурсов, нет и разделов доноров. PLM ищет разделы с избыточным количеством ресурсов (большим, чем им гарантировано). Остальные два раздела в группе имеют избыточные ресурсы. Раздел 1 имеет наибольшее соотношение «избыточные–общие ресурсы» из всех трех разделов, и ресурсы будут перемещаться от раздела 1 к разделу 3.

Рис. 2. Распределение ресурсов PLM

Если запрос ресурсов не может быть выполнен, он помещается в очередь и проходит повторную оценку, когда появятся свободные ресурсы.

PLM управляет памятью, перемещая логические блоки памяти LMB (Logical Memory Blocks) между разделами. Размер LMB зависит от количества памяти, установленной в хост-платформе (CEC). Для определения потребности в памяти PLM использует две метрики:

– Процент утилизации (соотношение используемой и установленной памяти).

– Скорость замещения страниц (page replacement rate).

ОС AIX использует всю доступную ему память. Он не будет выгружать страницы из памяти, если ему не потребуется загрузить другие страницы с диска. Это означает, что если есть избыток памяти, то AIX 5L будет использовать ее и она будет показана как используемая инструментами ОС, даже если нет приложений, использующих ее. По этой причине разделы редко становятся донорами.

Для разделов с выделенными процессорами PLM перемещает физические процессоры (по одному) от разделов, которые не используют их или имеют больший вес избыточности, разделам, которые имеют потребность в них. Это позволяет активным разделам с выделенными процессорами лучше использовать свои ресурсы, например, выравнивая переход от транзакций конца дня к ночным пакетным работам.

Для разделов в общем процессорном пуле PLM управляет выделенной мощностью и количеством виртуальных процессоров (VP). Когда раздел запрашивает больше процессорной мощности, PLM увеличит выделенную мощность для запрашивающего раздела, если дополнительная процессорная мощность доступна. PLM может увеличить количество виртуальных процессоров для увеличения потенциальной возможности раздела потреблять процессорные ресурсы при сильной загрузке для разделов с ограничением (capped) и без ограничения (uncapped). PLM может также, наоборот, уменьшить выделенную мощность и количество виртуальных процессоров при низкой нагрузке для более эффективного использования физических процессоров.

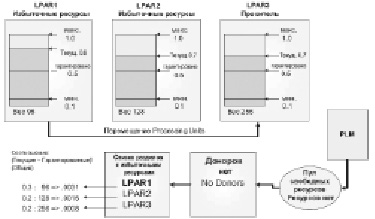

Далее на рис. 3 и 4 показаны основные этапы задания параметров файла политики управления ресурсами.

Рис. 3. Общие характеристики файла политики

Рис. 4. Критерии управления ресурсами

Другими словами, заданные параметры управления ресурсами – являются критериями оптимизации структуры виртуального сервера, причем основная часть необходимой информации для принятия решения собирается в виде статистики в ходе работы системы.

Аналогичным образом, в моделях таких ВС задаются триггеры адаптивности с критериями специфичными для модели [6], например, можно задать следующие условия срабатывания триггеров адаптивности:

1) Коэффициент загрузки в заданных пределах или больше/меньше определенного значения, т. о. можно управлять эффективностью загрузки ресурсов;

2) Среднее время пребывания заявки в СМО – аналогично среднему времени пребывания заявки в том или ином компоненте реальной ВС и соответственно нужно стремиться к тому, чтобы расчетное время не превышало более чем в 2 раза заданное время обслуживания, иначе получается, что заявка слишком трудоемка для полной обработки за один проход и из-за этого начнут образовываться очереди;

3) Среднее время ожидания в очереди – аналогично среднему времени ожидания заявки в каком-либо буфере, например, ОП по отношению к ЦП или буфер В/В по отношению к УВВ, а поскольку объем буферов в реальной ВС ограничен, то следует стремиться к тому, чтобы значение этого параметра не превышало N-го числа раз от заданного времени обслуживания.

Таким образом, адаптивные модели выгодны тем, что в процессе выработки решения используется информация, поступающая как от самой модели, так и от исследователя, в виде схем принятия решения, которые задаются исследователем.

Библиографическая ссылка

Терешкин Д.О., Мартышкин А.И. УПРАВЛЕНИЕ РЕСУРСАМИ И РАБОЧЕЙ НАГРУЗКОЙ В АДАПТИВНЫХ МОДЕЛЯХ ВЫЧИСЛИТЕЛЬНЫХ СИСТЕМ // Научное обозрение. Педагогические науки. 2019. № 3-2. С. 96-100;URL: https://science-pedagogy.ru/ru/article/view?id=1965 (дата обращения: 14.11.2025).

science-review.ru

science-review.ru